KNN

近朱者赤近墨者黑,分类或者回归算法。

n_neighbors:找最近的n个邻居,然后根据n个邻居判断它为什么。在机器学习库中,默认为5.

weights:默认是uniform, 参数可以是uniform、distance, 也可以是用户自己定义的函数

- uniform: 是均等的权重, 就说所有的邻近点的权重都是相等的

- distance: 是不均等的权重, 距离近的点比距离远的点的影响大

- 用户自定义的函数, 接收距离的数组, 返回一组维数相同的权重

leaf_size: 默认是30, 这个是构造的kd树和ball树的大小. 这个值的设置会影响树构建的速度和搜索速度, 同样也影响着存储树所需的内存大小. 需要根据问题的性质选择最优的大小

p : minkowski距离度量里的参数. p=2时是欧氏距离, p=1时是曼哈顿距离,对于任意p, 就是minkowski距离

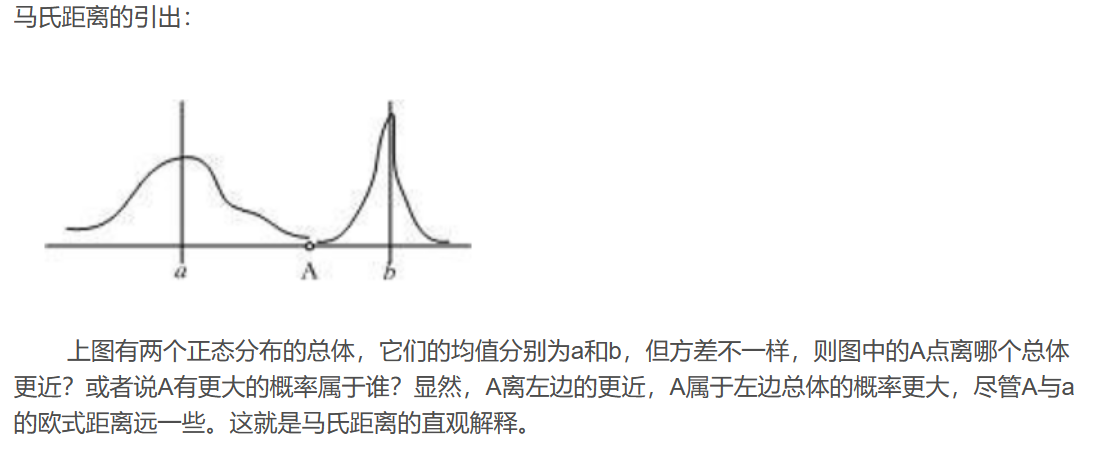

注:欧式距离为两个点的实际距离;曼哈顿距离为出租车距离,即遵守正南正北、正东正西方向规则;马氏距离:概率论距离,即基于样本分布距离。

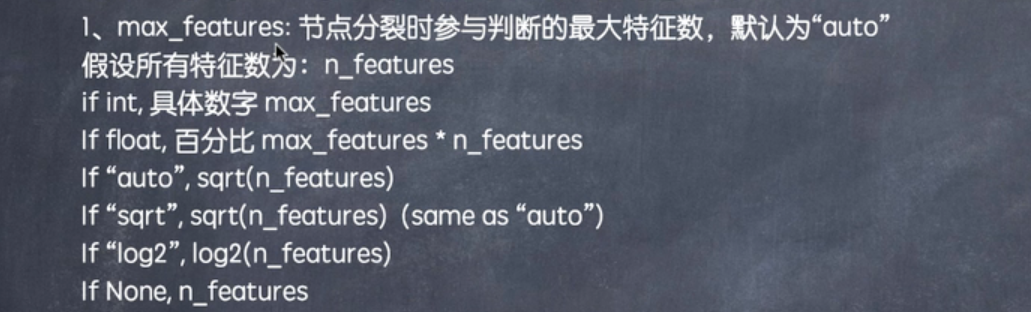

随机森林

n_estimators:树的个数(学习器的个数),提高数值,提高模型准确率,但是训练时间变长

max_depth:树的最大深度

决策树

超参数介绍参考随机森林

SVC

kernel:核函数

C:惩罚参数

- 错误项的惩罚系数。

- c越大,即对分错样本的惩罚程度越大,因此在训练样本中准确率越高,但是泛化能力降低,也就是对测试数据的分类准确率降低。

- 相反,减小c的话,允许训练样本中有一些误分类错误样本,泛化能力强。

- 对于训练样本带有噪声的情况,一般采用减小c的方法,把训练样本集中错误分类的样本作为噪声2.

AdaBoost

n_estimators:为弱学习器的数量‘

learning_rate:为弱学习器的权重缩减系数。